Editor’s Comment

제스처 기반의 인터페이스를 근미래의 일상으로 앞당겨 보여주었던 영화 〈마이너리티 리포트〉가 개봉한 것이 2002년의 일입니다. 스마트폰의 등장 이후 터치가 우세종이 되었고, 이어 음성이 말 그대로 ‘어시스턴트’로서 일상화된 지금, 허공의 제스처도 그렇게 될까요? AR 장비가 보편화된다면 그럴지도요. 12년 전 오늘의 뉴스는 저렴한 라이크라 장갑으로 제스처 기반 인터페이스를 구현한 MIT의 두 연구자의 작업입니다.

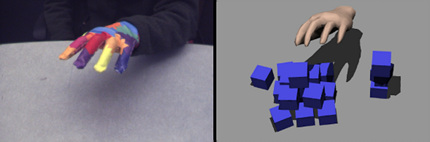

제스처 기반의 인터페이스를 이야기할 때마다 거론되는 영화가 있으니, <마이너리티 리포트>다. 지난 달 TED에 영화 속 바로 그 ‘데이터 인터페이스’의 실제 창안자인 존 언더코플러(John Underkoffler)의 발표 영상이 올라왔다. 그는 이 자리에서 ‘G-스피크’를 시연하며, 데이터를 익숙한 ‘공간’의 체계 안에서 탐색하는 모습을 보여주었다. 이것이 지금 제스처 기반 인터페이스의 최전선이라면, 여기 어느 대학원생의 인터페이스도 그에 못지 않다. 필요한 장비도 그리 거창하지 않다. 컴퓨터 웹캠에 알록달록한 라이크라 장갑이 전부이다.

MIT 컴퓨터과학 & 인공지능 연구소의 대학원생 로버트 왕(Robert Wang)과 부교수 요반 포포비치(Jovan Popović)가 공동으로 ‘저렴한’ 제스처 기반 인터페이스를 개발했다. 장갑은 열 가지 서로 다른 색상의, 스무 가지 얼룩들로 나뉘어 있다. 웹캠이 이 색상들의 대비를 인식, 손의 움직임과 제스처를 스크린 위 손의 3D 모형에 반영한다. 말하자면 마우스와 포인터가 손과 손의 3D 모델로 대치한 셈이다.

로버트 왕과 요반 포포비치의 인터페이스는 특히 비디오 게임 분야에 적합해 보인다. 플레이어는 게임 속에서 아이템을 집거나 무기를 쥐고 휘두르는 등의 행동을 보다 실감나게 컨트롤할 수 있을 것이다. 왕과 포포비치는 이 인터페이스가 공학자와 디자이너들에게도, 보다 쉽고 직관적으로 3D 모델을 다루는 데 도움이 될 것으로 보고 있다.

© designflux.co.kr